¿Eres de derechas o de izquierdas?

Llevo bastante tiempo escuchando a fotógrafos discutir sobre dos “tendencias” a la hora de exponer en fotografía digital: por un lado, los que dicen que lo correcto es derechear el histograma siempre que se pueda y, por otro, aquellos que prefieren subexponer. Cada cual defiende sus motivos y a mí no acababa de quedarme claro cuál era la opción correcta, si es que eso existe.

Así que me puse a investigar sobre el tema para buscar respuestas y he reunido lo esencial en este artículo. Empezaré describiendo de una manera sencilla el funcionamiento de un sensor digital, para hablar después de las dos técnicas y terminar con un ejemplo práctico.

Cómo funciona un sensor digital

Dejemos a un lado la película: esto solo aplica a las cámaras digitales, cuyo componente fotosensible es un sensor, un sistema electrónico bastante complejo cuyo funcionamiento se puede simplificar (mucho) así:

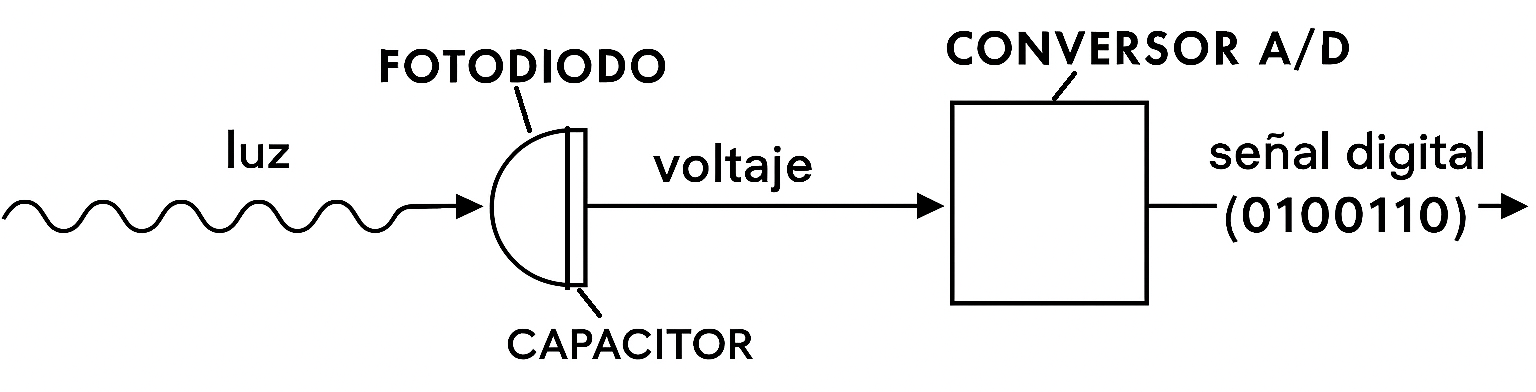

La luz (radiación electromagnética) es recogida por un fotodiodo y convertida en carga eléctrica o voltaje, que a su vez es procesada por un conversor analógico/digital para transformarla en una señal binaria (una serie de unos y ceros).

Para la cuestión que nos ocupa vamos a olvidarnos de la gestión del color, porque complica bastante la explicación con componentes adicionales que no necesitamos, como la matriz Bayer. Y tampoco vamos a entrar en detalles sobre el funcionamiento de las diferentes tecnologías de sensores. Se trata de simplificar el proceso al máximo. Imaginaremos, pues, que nuestra cámara fuera en blanco y negro y que el sensor realiza esos dos pasos: de luz a voltaje y de este a señal digital.

Como decía en el párrafo anterior, la manera específica en que estos componentes electrónicos se estructuran es diferente según la tecnología del sensor (CCD, CMOS…), pero lo que nos importa en este punto es que al final consiste en una matriz de X filas por Y columnas de unos cuadraditos denominados píxeles, cada uno de los cuales capta luz de un punto de la escena. En esencia, cuanta más luz le llega a un píxel, más carga eléctrica acumula y mayor es el número binario resultante.

Clave 1: rango dinámico y ruido digital

Bien, dependiendo de varios factores como su construcción técnica, el tamaño de los fotodiodos, etc., el sensor tendrá más o menos rango dinámico. Concepto muy importante que se refiere a la intensidad de luz que es capaz de captar sin saturarse. A mayor rango, más diferencia entre las zonas oscuras y las más iluminadas será capaz de registrar. Los sensores de las primeras cámaras (allá por los 2000) tenían menos rango dinámico que los actuales, y también gestionaban peor el ruido.

¿Qué es el ruido? Fluctuaciones aleatorias que se suman a la señal y la “ensucian”. Es inevitable: la propia llegada de fotones es variable (ruido de disparo o shot noise); en el proceso de lectura y digitalización aparecen fluctuaciones adicionales (ruido de lectura o read noise); y, además, se generan electrones por efecto térmico incluso sin luz (corriente oscura o dark current), cuya contribución aumenta con la temperatura y con el tiempo de exposición.

Una medida de la calidad de un sensor digital es el ratio señal/ruido (signal-to-noise ratio o SNR). Cuanto más alto, mejor. El ruido tiende a notarse más en las áreas oscuras de una imagen precisamente porque en ellas la señal luminosa es baja y el SNR disminuye. En la imagen, el ruido se traduce en la aparición de píxeles de colores que no tocan (ruido cromático) y granulado de luminancia. Pero no, no se parece en nada al grano de la película, ya le gustaría.

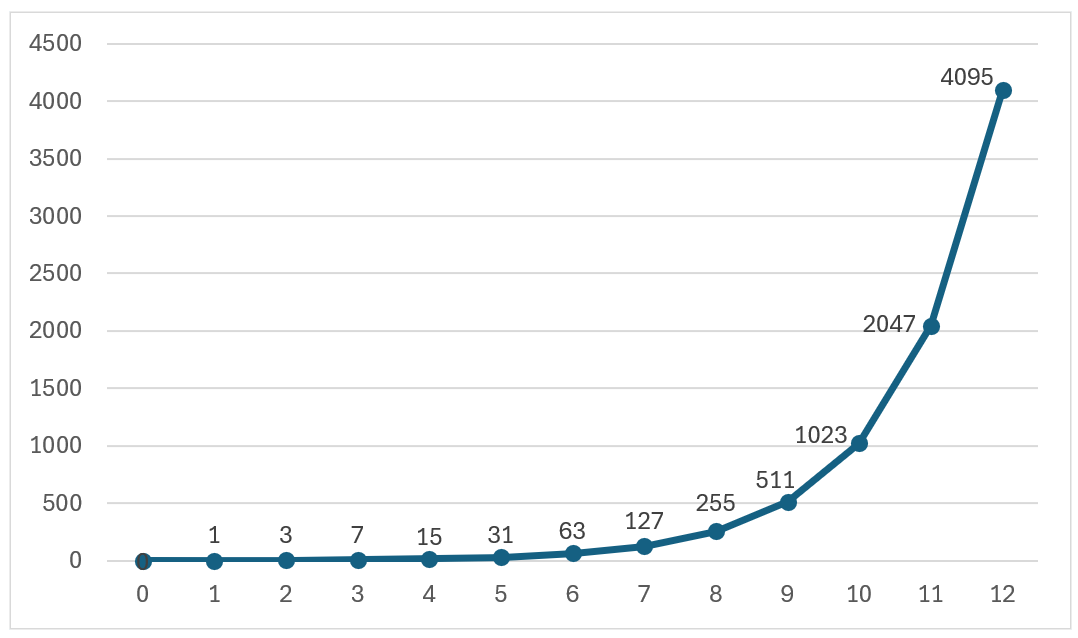

A quién no le va a gustar una función exponencial…

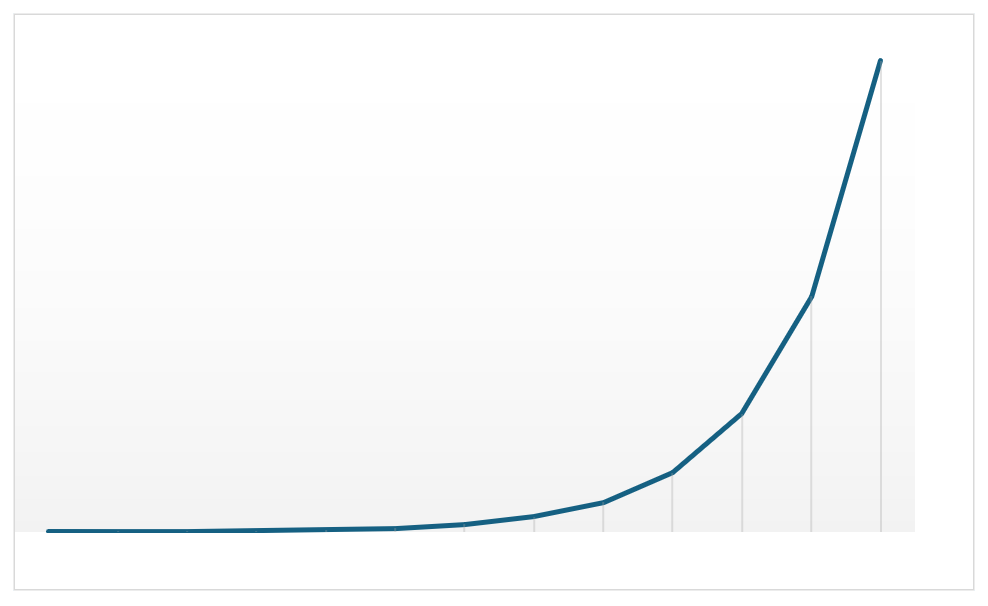

El rango dinámico o RD de un sensor se mide en pasos de luz. ¿Por qué? Pues por qué no. Parece más apropiado que medirlo en litros o en m/s. Por lo general, un sensor actual tiene unos 12 o 14 pasos de RD, frente a los 20 a los que pueden llegar nuestros ojos adaptando la pupila. O sea, no es capaz de procesar tanta luz como el ser humano. Pero el dato clave de los pasos es que avanzar uno duplica la cantidad de luz y retroceder uno la divide a la mitad. ¿Por qué? Porque una función exponencial es mucho más chula que una lineal, dónde va a parar. No, en serio, sigue la misma lógica que los diafragmas, donde también sumar o restar una apertura duplica o divide por dos la cantidad de luz que le entra a la cámara.

Recapitulando hasta aquí: el sensor registra la luminosidad de la escena hasta donde le dé su rango dinámico. Por encima de su umbral de luminosidad se saturará, mostrando píxeles como cuadraditos completamente blancos y también será inevitable que registre cierta cantidad de ruido.

Clave 2: profundidad de bits

Una vez hemos entendido cómo un sensor recoge la luminosidad, queda por explicar cómo esta se convierte en información digital. En el esquema de más arriba veíamos que después de procesar la luz a señal eléctrica, aparecía otro componente llamado conversor A/D. Este es el encargado de traducir la señal analógica (eléctrica) en señal digital (unos y ceros).

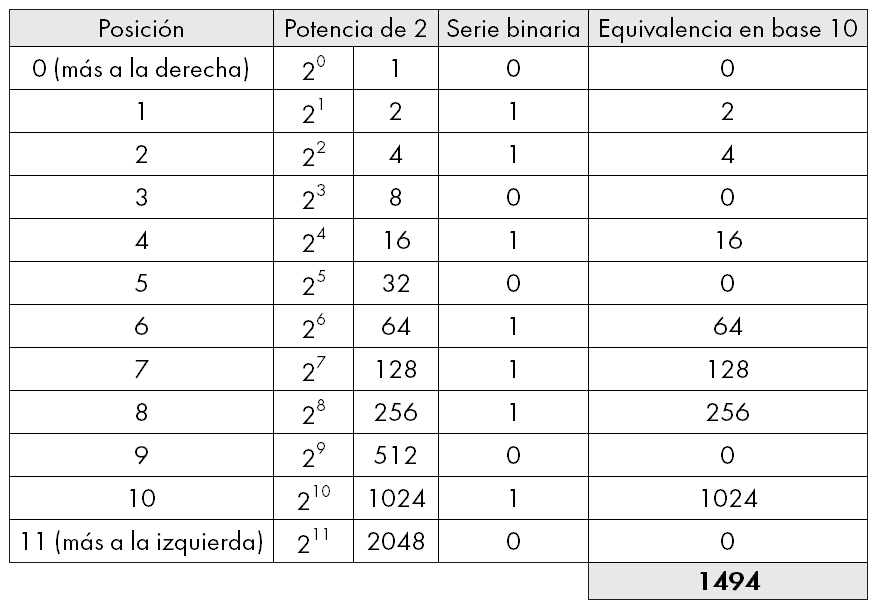

Aquí llega el segundo factor clave: la profundidad de bits. Es decir, la longitud de esa serie de unos y ceros. Cuanto más larga la serie, más valores distintos puede codificar. En nuestra vida cotidiana usamos una codificación numérica en base 10, es decir, tenemos diez dígitos distintos que combinamos para obtener todos los números posibles. El valor de un dígito cambia según la posición que ocupa en la cadena: no es lo mismo tener 5€ que 50€ que 500€ que 5000€, ¿verdad? Pues en informática se trabaja en base 2, por tanto solo hay dos dígitos distintos (el 0 y el 1) que, según su posición también cambian de valor.

Una cámara digital actual tiene una profundidad de 12 bits o más. O sea, las series binarias en que el conversor A/D traduce las señales eléctricas son cadenas del tipo 010111010110. ¿Y este número en cristiano cuál es? Pues 1.494, está claro (jeje). Para hacer el cálculo hay que recordar que cada posición en la cadena, empezando por la derecha, representa el valor de 2 elevado a la potencia de su posición. Si en la serie hay un 1, esa posición cuenta, si hay un 0, no cuenta. Al final sumamos todos los valores de las posiciones donde había un 1:

La vida es mejor con Excel.

Entonces, con una profundidad de 12 bits, el mayor valor que se puede representar es 4.095. Si la cámara tuviera una profundidad de 14 bits, podríamos representar hasta 16.383. Si solo tuviera 6 bits de profundidad, tendríamos 63 como mayor valor.

¿Y esto qué importancia tiene? Mucha, puesto que a más valores más gradación tonal habrá entre el menor valor (el negro) y el mayor (el blanco). Dicho de otra manera: la profundidad de bits nos da la cantidad de “escalones” que el sensor puede codificar desde sus umbrales de negro y de blanco, que a su vez dependen del rango dinámico, o sea, de la intensidad de luz que puede registrar sin saturarse.

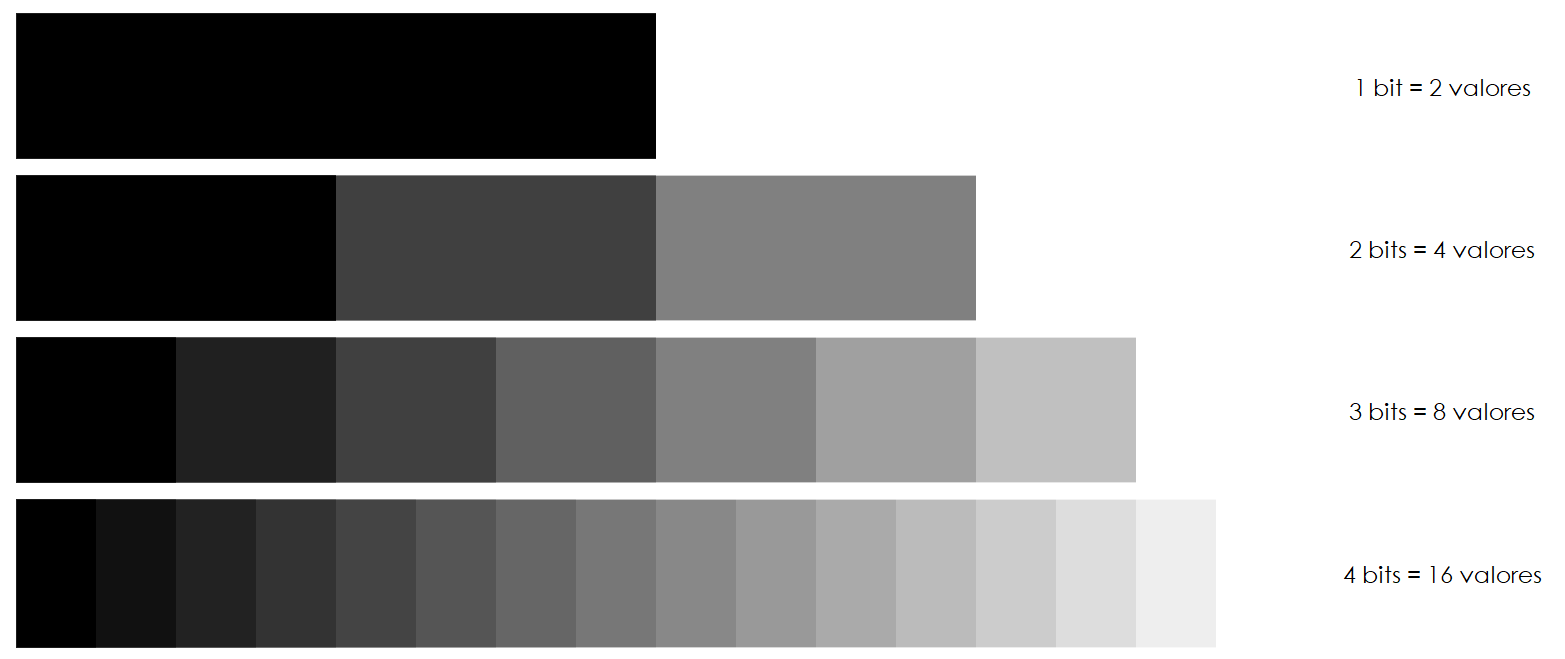

Esto se entiende estupendamente con un dibujito:

Con una profundidad de 1 bit solo podemos representar dos “escalones” o tonos de gris, el blanco y el negro. Con 2 bits podemos representar 4 tonos, con 3 bits, 8, con 4, 16… y así sucesivamente. Como la escala es exponencial (potencias de 2) cada bit que añadimos supone duplicar los tonos. Por eso, con 12 bits llegamos a 4.096 tonos en total, del 0 (negro) al 4.095 (blanco). La correspondencia entre la luminosidad real de la escena fotografiada y su representación en la imagen digital será bastante buena, porque hay muchos “escalones” para asignar a cada nivel de luz.

Cómo se relacionan el rango dinámico y la profundidad de bits

Ahora que ya hemos entendido los dos aspectos clave del sensor, falta entender cómo se relacionan, y esto es esencial para explicar después lo del derecheo. Como he explicado antes, cada bloque del RD representa el doble o la mitad de luz que el adyacente, pero los 4.096 valores de gris son una gradación lineal del 0 (negro) al 4.095 (blanco). ¿Entonces?

Entonces, si nos fijamos en la gráfica anterior, los 4.096 valores, que están en el eje vertical, tienen que repartirse siguiendo la función exponencial que marca el rango dinámico en el eje horizontal. El paso 12, por tanto, que corresponde con el rango más luminoso, acumula la mitad de los valores de luminosidad y, a medida que nos desplazamos hacia la izquierda, hacia el negro, en cada paso los valores restantes se dividen por dos. Cuando llegamos al paso 1, el más oscuro, solo nos queda un valor, pobre.

He oído decir a algún fotógrafo que “mi sensor no hace eso”. Bueno, sí lo hace. Todas las cámaras digitales de uso general comercializadas actualmente, sean de la gama que sean, comparten estos principios de funcionamiento. Las diferencias vienen por el tamaño del sensor, la resolución, el rango dinámico, la profundidad de bits y, por supuesto, la calidad de los componentes que procesan la señal. Pero, en esencia, la lógica es esta.

Derecheo del histograma o ETTR

Toda esta larga explicación previa era necesaria para llegar hasta aquí: por qué muchos fotógrafos recomiendan aumentar la exposición en cámara digital lo más posible hacia la derecha sin llegar a saturar el sensor. Este detalle es fundamental para evitar quemar las altas luces, es decir, tener píxeles completamente blancos sin ninguna información ni textura.

Su lógica es que, exponiendo de esta manera, aprovechamos al máximo la capacidad tonal del sensor, puesto que se codifica mucha más información digital en las luces que en las sombras. Con este sistema mejoramos el SNR, que es como decir que reducimos el ruido y la sobreexposición en cámara es recuperable en posproducción, siempre que no hayamos quemado las altas luces, insisto.

Uno de los primeros artículos que se publicaron al respecto, y que popularizó esta técnica, fue el de Michael Reichmann en 2003.

En la práctica, ¿cómo se hace esto del derecheo, o, en inglés, Expose To The Right? Cada uno tendrá su método; el mío es usar la medición en puntual, identificar el área más luminosa de la imagen y apuntar el fotómetro de la cámara hacia ahí. Sé que el rango dinámico de mi cámera me permite sobreexponer ese punto hasta dos pasos (cada cual tendrá que hacer las pruebas con su equipo), con lo que, según la lectura del exposímetro, ajusto, bien diafragma, bien obturador para asegurarme de que las altas luces no estallan. Como tengo una cámara sin espejo veo tanto los valores como el histograma en el visor electrónico. Si tienes una cámara DSLR, necesitarás mirar la pantalla, salvo que tengas el ojo tan entrenado que no necesites ese apoyo, claro.

Ojo: aunque el histograma de la cámara da una información bastante más fiable que la pantalla de la cámara, tampoco es totalmente exacto, ya que se basa en la previsualización del JPG, no en la información del RAW. Por tanto, puede avisar de clipping o estallido en las altas luces cuando en realidad todavía hay margen. Eso es porque el JPG siempre tiene menos rango tonal que el RAW.

Esta técnica no es una ciencia exacta, ni tampoco es obligatorio usarla. El riesgo de quemar las luces existe y tiene difícil arreglo. Por otro lado, sobreexponer deliberadamente en la toma obliga a disparar en RAW y posproducir después. Si no, es absurdo hacer ETTR.

Subexponer por defecto o ETTL

El ETTR ha sido, en las dos primeras décadas de vida de la fotografía digital, el mantra a seguir. Pero recientemente algunos fotógrafos razonan que, con las mejoras de los sensores, el ruido ha disminuido notablemente, mientras que una luz quemada sigue siendo irrecuperable. Frente al riesgo de no medir bien y sobreexponer de más, opinan que es más práctico subexponer, o Expose To The Left para proteger las altas luces y recuperar las sombras después en posproducción. Y si aparece el ruido, existen unos estupendos algoritmos denoise para eliminarlo. La ETTL no es, propiamente dicho, una técnica como la ETTR, más bien un hábito de algunos fotógrafos, especialmente de paisaje.

En realidad, subexponer a propósito no aporta una ventaja técnica de relación señal/ruido como sí lo hace ETTR. Se trata más bien de una decisión pragmática de algunos fotógrafos porque prefieren trabajar desde las sombras o para proteger las altas luces, especialmente apropiada en situaciones en las que hay que disparar deprisa o la luz es muy cambiante, sabiendo que, a pesar de la subexposición, capturan suficiente información en las sombras que después se puede levantar sin riesgo en posproducción.

Un ejemplo práctico

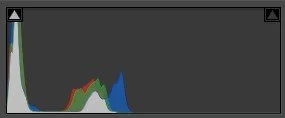

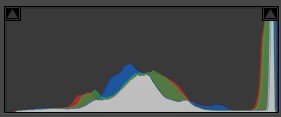

Aquí tenemos dos versiones del mismo paisaje, a la izquierda con ETTL y a la derecha con ETTR, y sus respectivos histogramas debajo:

Evidentemente, las dos imágenes están mal expuestas y han de ser corregidas en posproducción. Para este ejemplo me he limitado a aplicar el perfil Adobe Color Adaptativo, que realiza un mapeo tonal y del color basado en IA. Este es el resultado:

Aparentemente son muy parecidas, pero basta con ampliar un poco la imagen, por ejemplo sobre esa nube lenticular de la derecha para ver la diferencia:

En efecto, la subexposición produce un nivel de ruido muy superior. Que sí, que es fácil de eliminar por software, y también, las cámaras de alta gama generarán menos, pero lo que yo me pregunto es: ¿por qué “hacer ruido” en primer lugar si puede evitarse? ¿No parece una técnica más correcta derechear el histograma sin quemar las luces?

Conclusión

Como ocurre casi siempre en fotografía, la respuesta correcta a la pregunta es: depende. No es lo mismo hacer paisaje que retrato. No es lo mismo una escena de bajo que de alto contraste. Y, por supuesto, también depende del efecto expresivo y estético que busque el fotógrafo. Lo cierto es que hacer ETTL es “fácil”, en el sentido de que no hay que medir cuidadosamente la luz, mientras que ETTR requiere más tino pero, a pesar del riesgo de quemar las altas luces, reduce en gran medida el ruido. Por tanto, lo adecuado es estudiar primero la luz de la escena, pensar, y después decidir si es más apropiado subexponer, sobreexponer o exponer correctamente, ¡que, ojo, también es una opción!

Si quieres leer más sobre el tema, hay mucha información disponible en Internet. Un buen artículo es este de Nasim Mansurov (en inglés).

Notas:

La ilustración de inicio ha sido generada con Sora IA.

Este artículo no contiene enlaces afiliados.

Todas las fotografías, tablas y diagramas de este artículo son originales y de elaboración propia.

Mi agradecimiento a todos los fotógrafos a los que he dado la tabarra durante una semana preguntándoles por sus hábitos a la hora de exponer. Gracias a todos por vuestros comentarios.